谷歌Gemini能耗揭秘:单次查询能耗极低,环保性能突破预期

- 科技资讯

- 2025-12-25

- 677

大型人工智能模型的电力消耗问题日益引发公众关注,社会舆论持续发酵,质疑声浪一波高过一波。

对此,谷歌近期以扎实的硬核数据作出强势回应,旨在扭转公众认知。

数据显示,单次Gemini查询所需能耗中位数仅为0.24瓦时,这大致相当于家用微波炉运转一秒所消耗的能量,其碳排放当量仅为0.03克二氧化碳,甚至低于人类一次排气所产生的碳排放,同时还会消耗约5滴淡水。

(文中引用的所有数据均基于中位数统计)

谷歌首席科学家Jeff Dean公开宣称:

这一能耗水平显著低于公众普遍预估的范围。

事实上,以谷歌为代表的领先大模型厂商,长期以来一直致力于探索并实践降低人工智能系统资源消耗的路径。

在短短一年内,通过持续的模型架构优化与大幅增加清洁能源的使用比例,Gemini的能源消耗已降至原先的1/33,碳排放量锐减至1/44,与此同时,其生成的响应质量却得到了进一步提升。

接下来,让我们深入探究谷歌是如何系统性地衡量并有效削减人工智能的能源足迹的。

全面衡量人工智能的能源消耗

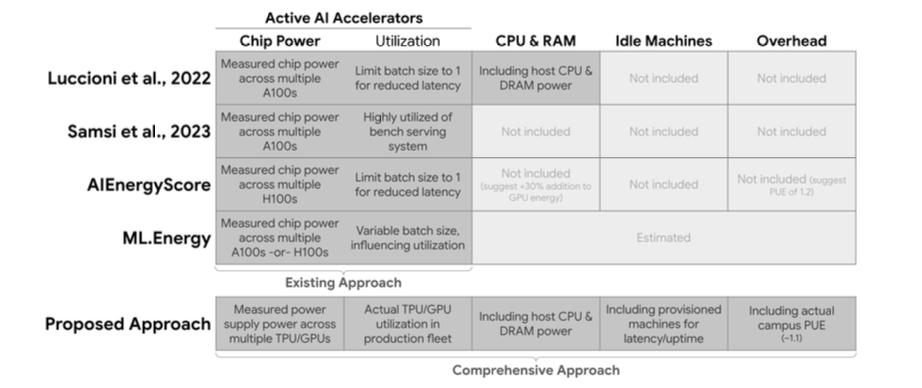

谷歌首先指出,当前许多关于AI能耗的估算往往基于理论上的最大效率,未能真实反映其在大规模生产环境中的实际运行状况。

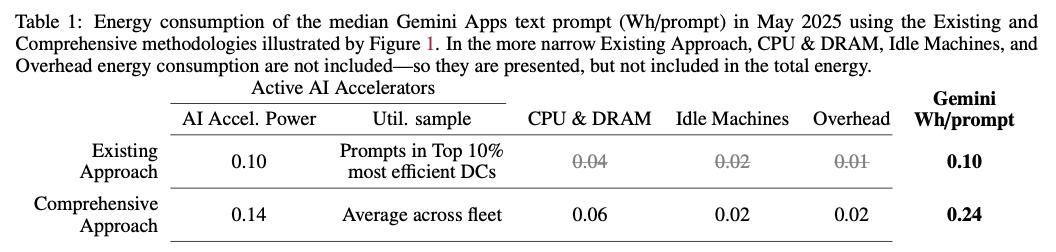

如果仅计算TPU和GPU等核心加速器的消耗,一次Gemini查询理论上仅需0.10瓦时,排放0.02克二氧化碳当量,耗水量约为0.12毫升。

然而,这种简化的计算方式只聚焦于硬件在负载下的直接能耗,而忽略了支撑AI服务稳定可靠运行所必需的一系列关键系统性因素。

对此,Jeff Dean进一步阐述道:

人们普遍在担忧:人工智能是否会成为能源消耗的无底洞?它是否会对地球环境造成显著的碳足迹伤害?

因此,谷歌针对AI服务在生产环境中的真实场景,开发了一套更为周密和全面的能源与资源消耗评估体系,主要涵盖以下几个核心维度:

全系统动态功率考量

这不仅计量了主AI模型推理计算所直接消耗的能源和水资源,还纳入了大规模运行时芯片的实际利用率。在实际操作中,芯片利用率往往远低于其理论峰值性能,这一因素必须被计入。

空闲计算资源的能耗

为了确保服务的高可用性与系统可靠性,生产环境必须预留一定的冗余计算容量以应对流量高峰或硬件故障。这些处于待命状态的空闲芯片同样持续消耗能量,这部分能耗必须纳入总碳足迹计算。

主机CPU与内存的贡献

AI模型的运行并非仅依赖于TPU或GPU等专用加速器。宿主服务器的中央处理器(CPU)和内存也在提供支持服务、管理任务和数据传输中扮演关键角色,并消耗相应能源。

数据中心基础设施开销

运行AI的信息技术设备所消耗的电力只是整体能耗的一部分。支撑这些计算设备的基础设施,例如冷却系统、电力配送单元以及其他辅助系统,同样会产生显著的能源开销。这部分开销通常通过电力使用效率(PUE)这一关键指标来衡量。

数据中心的用水量

为了有效降低能耗及关联排放,数据中心广泛采用水冷方式进行散热。随着AI系统在能效方面的不断优化,其整体淡水消耗量也会同步自然下降。

通过上述这套全面综合的评估方法,谷歌得出的结论是:单次Gemini查询消耗0.24瓦时能量,排放0.03克二氧化碳当量,同时消耗大约5滴淡水。

那么,谷歌是如何实现如此卓越的能效表现的呢?

Gemini实现超低能耗的核心策略

谷歌强调,Gemini显著的效率提升源于其在人工智能研发中贯彻的“全栈式”优化理念。从定制硬件、高效模型架构,到支撑模型运行的强大软件与服务系统,他们在每一个技术层级都深度融合了能效优化设计。

首要的是革命性的高效模型架构。Gemini基于谷歌研究人员开发的先进Transformer框架构建,与早期的语言建模架构相比,其计算效率提升了10倍至100倍。

此外,模型设计中还集成了诸如混合专家系统(MoE)和混合推理等创新机制,从而大幅减少了不必要的计算量与数据传输,全面提升了系统运行效率。

同时,Gemini通过精准量化训练(AQT)等一系列尖端技术持续优化,使得模型在确保回答准确性和丰富性的前提下,进一步降低了能源需求。

在推理与服务优化层面,谷歌不断革新AI的交付方式,以提升响应速度与整体资源利用率。

例如,通过推测解码技术,可以由较小的模型预先推测后续令牌,再由较大的核心模型快速验证,从而用更少的硬件资源生成更多的响应。

知识蒸馏技术则利用大型“教师模型”来训练出更小巧、更高效的“学生模型”(如Gemini Flash和Flash-Lite),用于实际部署服务。

不仅如此,为实现能耗最小化,谷歌在硬件层面坚持定制化路线。

过去十余年,他们始终坚持从零开始设计张量处理单元(TPU),旨在最大化每瓦特电力所能带来的计算性能。同时,他们协同优化AI模型与TPU硬件,确保软件能充分挖掘硬件潜能,而硬件也能高效适配未来AI软件的发展。

值得强调的是,最新一代的Ironwood TPU在能效上相比首代公开TPU高出30倍,在推理任务中的表现远超通用CPU。

接下来,是优化空闲资源利用率。谷歌的服务堆栈能够高效调度CPU资源,并根据全球实时查询需求动态分配模型计算任务至TPU,近乎实时地调整,从而最大限度地减少TPU的闲置时间,摒弃了传统的“一次部署、永久运行”的粗放模式。

同时,其XLA机器学习编译器、Pallas内核以及Pathways系统,使得通过JAX等高级框架表达的模型计算,能够在TPU服务硬件上实现极高效率的执行。

再看谷歌的超高效数据中心,其全球数据中心的平均电力使用效率(PUE)已达到业界领先的1.09,属于全球能效最高的数据中心阵营。

最后,在数据中心运营与环境责任方面,谷歌持续增加对风能、太阳能等清洁能源的采购与使用,朝着实现“全天候无碳能源”运营的目标迈进。同时,他们致力于补充其办公室和数据中心平均消耗量120%的淡水。

此外,通过科学的流域健康评估,谷歌优化冷却系统策略,平衡能源消耗、水资源利用和碳排放之间的本地化权衡,以此指导冷却技术的选择,并在水资源紧张地区主动实施用水限制。

参考链接:

[1]https://x.com/JeffDean/status/1958525015722434945

[2]https://cloud.google.com/blog/products/infrastructure/measuring-the-environmental-impact-of-ai-inference/

本文由主机测评网于2025-12-25发表在主机测评网_免费VPS_免费云服务器_免费独立服务器,如有疑问,请联系我们。

本文链接:https://vpshk.cn/20251212485.html