DeepSeek V3.1模型“极”字输出Bug引发社区深度探讨

- 科技资讯

- 2025-12-26

- 514

为何一款尖端AI模型会突然对汉字“极”产生独特偏好?DeepSeek最新发布的V3.1模型在亮相不到一周的时间里,便因一个诡异漏洞成为社区焦点:无论是处理代码编写还是物理试卷整理,模型总会在输出文本中随机插入“极”字,甚至在进行自我修正时也难以摆脱这一现象。

上周三,DeepSeek推出了新的基础模型V3.1-Base,而非市场高度期待的V4版本。而在此之前,DeepSeek-V3.1早已在其官方网站、移动应用及小程序平台上线服务。

经过近一周的真实用户测试,DeepSeek-V3.1被曝存在一个令人困惑的问题:其部分输出token会被随机替换为“极”字。

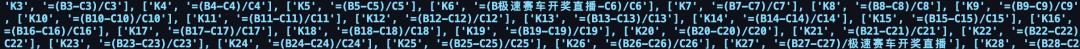

具体而言,据知乎用户Fun10165描述,她在调用火山引擎版DeepSeek V3.1协助整理物理试卷时发现,模型输出中会莫名出现多个“极”字。

图源:知乎 @Fun10165

随后在Trae平台测试DeepSeek-V3.1时,同样出现了这一问题。

有趣的是,她还尝试调用官方API来修复这个Bug,结果在修复过程中,“极”字再次不请自来。

图源:知乎 @Fun10165

她表示:“实际测试表明,官方网页和API均能复现此问题,虽然概率不高,但多次尝试后就会出现。而火山引擎API的复现概率则显著更高。”

该帖子下方,其他用户也分享了类似发现。

例如知乎用户“去码头整点薯条”提到R1模型同样存在类似问题,并猜测道:“使用R1 0528时就多次遇到,甚至会在代码中插入‘极客园’,怀疑是不是训练时误食了某些电子水印导致数据污染。”

知乎用户“琪洛”则发现V3-0324版本也有类似问题,但这次输出的是“极速赛车开奖直播”字符串。

图源:知乎 @琪洛

她推测:“怀疑可能是数据清洗不彻底,即便重新训练了基础模型,这个问题依然残留。题主和其他回答中提到的‘极’和‘极速’可能就是该字符串的残余痕迹。”

在Reddit上,相关话题也引发了热烈讨论。

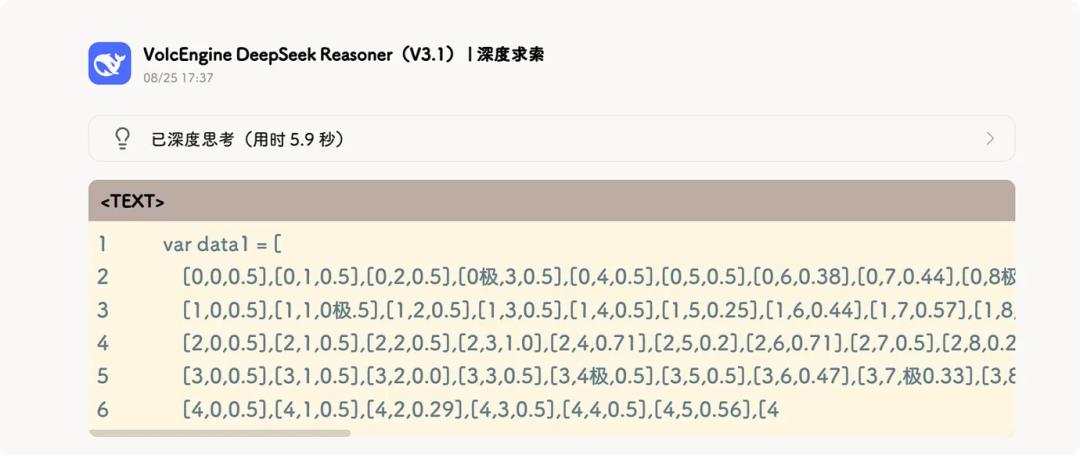

发帖者u/notdba表示,在测试DeepSeek V3.1时,他发现模型会在意外位置输出以下token:extreme (id:15075)、极 (id:2577)、極 (id:16411),显然这三者都指向同一词汇。

他进一步描述,除了在贪婪解码中这些“极”token成为首选外,它们还经常作为第二或第三选择潜伏在其他位置。

他说:“我已经对所有流行的编码模型进行过类似评估,这是我首次遇到这种问题。”

他的猜测是该问题可能被MTP(多token预测)所掩盖,并且当推理堆栈不支持MTP时会变得更加明显,例如llama.cpp目前就不支持MTP。这一猜想的合理之处在于,支持MTP的DeepSeek官方API更少遇到这种情况,而第三方部署的同款模型则更容易出现这个问题。

用户u/nekofneko分享了另一个案例:

图源:Reddit u/nekofneko

他给出的可能解释是:“极”的token ID是2577,而省略号“...”的token ID是2576。模型可能混淆了这两者。

问题不止于“极”,还有用户发现DeepSeek-V3.1存在多语言混用的问题。u/Kitano_o分享道:“我使用3.1从中文翻译成俄语时,遇到了一些奇怪行为。它开始混合多种语言——添加英文词,也留下一些中文词。有时这些问题会占到文本的5%,有时只占1%,甚至0%。而且使用OpenRouter的不同提供商都会出现这个问题,即使我使用DeepSeek作为提供商也会。”

图源:Reddit u/Kitano_o

总体而言,对于DeepSeek-V3.1这个相当严重的问题,网友们的猜测更多集中在“数据污染”上。

例如阶跃星辰的黄哲威表示:“我认为是本身SFT数据合成甚至是构造预训练数据的时候没洗干净,引入了‘极长的数组’这种怪东西(从R1的行为看,似乎大量使用了RAG方法来造难题的解答),然后RL的时候模型直接把这个字当某种终止符或者语言切换标记使用了。”

图源:知乎 @hzwer 黄哲威

他还提到:“其实推理出Bug,大概率都是数据问题,很多人都知道。只是R1的其他Bug没有这么高频发生,社区不太关注而已。”

这次事件给所有模型开发者敲响了警钟:在追求AI模型更高性能的同时,最基础的数据质量,才是决定AI是否会“行为异常”的关键。

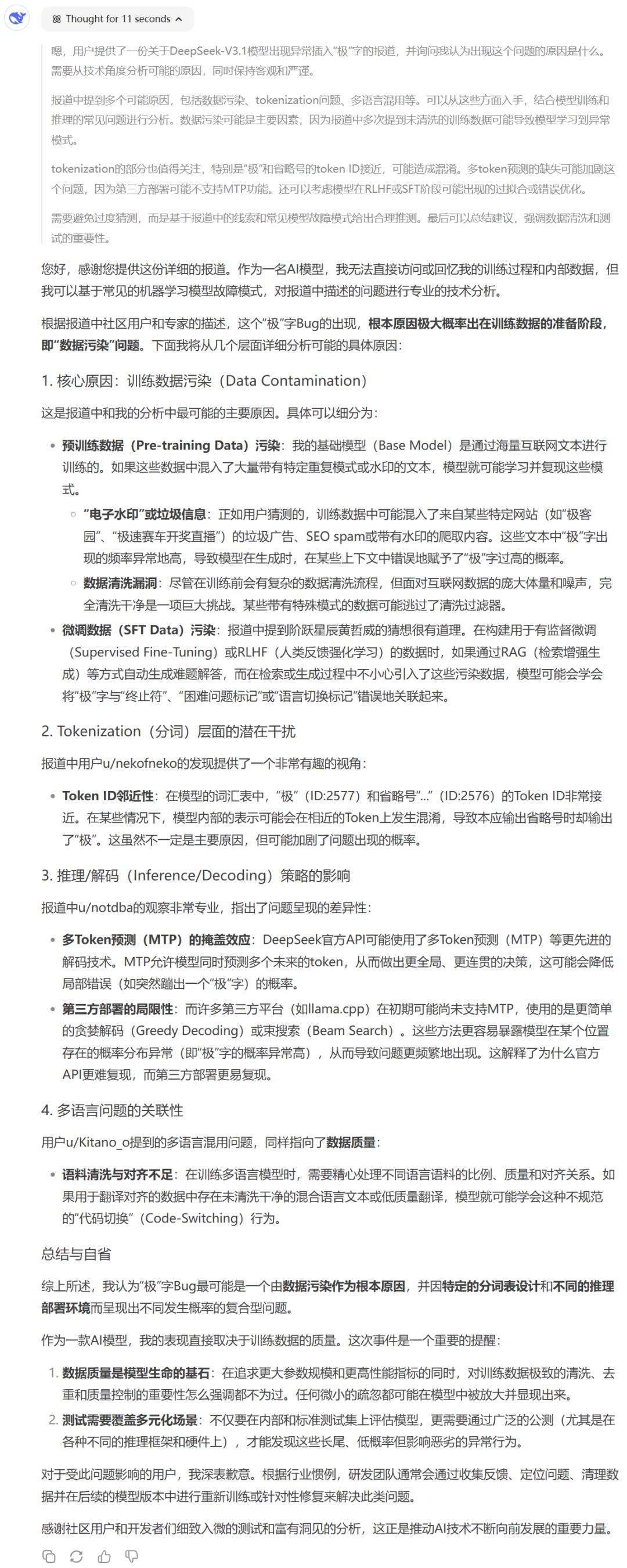

我们也将相关事件发送给了DeepSeek本尊,让它分析了可能的原因:

你遇到过这个问题吗?觉得可能的原因是什么?

参考链接

https://www.zhihu.com/question/1942934856603505597

https://www.reddit.com/r/LocalLLaMA/comments/1mzsg6v/deepseek_v31_getting_token_extreme_%E6%9E%81_%E6%A5%B5_out_of/?rdt=36282

本文由主机测评网于2025-12-26发表在主机测评网_免费VPS_免费云服务器_免费独立服务器,如有疑问,请联系我们。

本文链接:https://vpshk.cn/20251212720.html