DeepSeek率先响应AI生成内容标识新规,深度揭秘模型训练全流程

- 科技资讯

- 2025-12-27

- 351

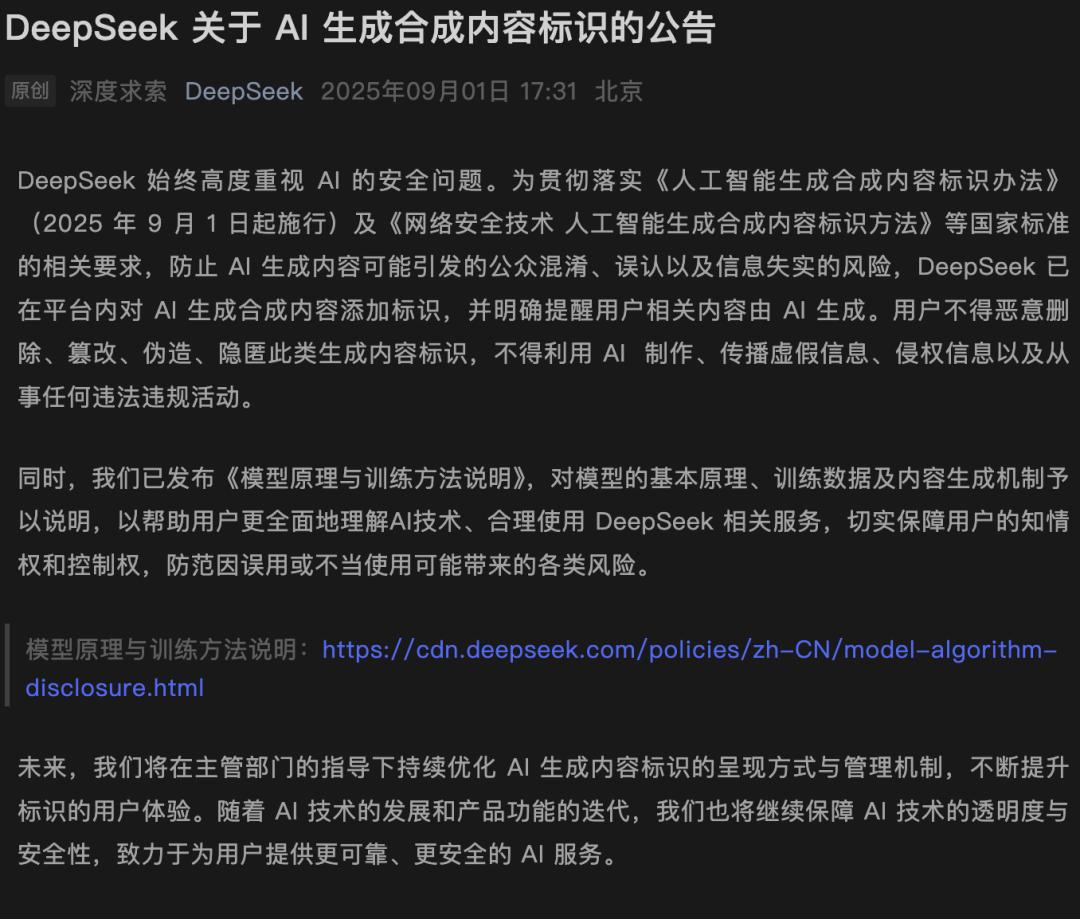

新规实施首日,DeepSeek即刻采取行动!未来,所有由自家AI生成的内容,均会明确标注「AI生成」身份。更为重要的是,DeepSeek主动公开了V3/R1模型的核心训练细节。

自今日起,国家互联网信息办公室发布的《人工智能生成合成内容标识办法》正式生效执行。

该办法第四条明确规定,需要对符合标准的AI生成合成内容添加清晰可见的标识。

紧随政策步伐,DeepSeek迅速做出响应。

近日,DeepSeek官方微博发布了最新公告——所有由人工智能生成的内容,都将显著标注「AI生成」字样。

公告同时严肃提醒用户,严禁故意删除、修改或隐藏标识,更不允许利用AI技术制作或传播虚假信息。

此外,DeepSeek同步发布了《模型原理与训练方法说明》文档,让外界得以窥见其技术实现路径。

接下来,我们将详细解读DeepSeek V3/R1模型的一些关键训练细节。

文档链接:https://cdn.deepseek.com/policies/zh-CN/model-algorithm-disclosure.html

应对新规要求,DeepSeek公开技术实现说明

DeepSeek详细阐述了大模型的训练与推理过程,涵盖了预训练、优化训练(微调)以及训练数据等核心环节。

各类大模型采用的神经网络架构对比

模型训练过程

模型训练阶段即模型的开发阶段:通过预设的深度神经网络架构与训练方法,研发人员构建出可投入实际使用的模型。

模型由多层神经网络构成,不同的架构设计直接影响模型的最终性能。同时,模型性能也受到参数规模的显著影响,而训练的本质即是确定这些参数的具体数值。

当前,先进大模型的参数数量已达到百亿乃至千亿级别。最新的DeepSeek-V3-0324模型,参数总量高达6850亿。

在训练过程中,这些参数通过梯度下降等优化算法进行迭代更新与调整。

DeepSeek将模型训练划分为预训练和优化训练两个主要阶段。

预训练:目标是通过海量数据训练模型,使其获得通用的语言理解与文本生成能力。

优化训练:也称为微调,是在预训练模型的基础上,利用特定任务的数据进一步调整模型参数,使其更好地适应实际应用场景的需求。

在预训练阶段,模型通过大规模的自监督学习,从文本数据中学习语言的潜在模式与知识关联。预训练完成后,模型能够理解和生成连贯的文本,但尚不具备精准回答问题或执行指令的能力,因此需要进行进一步的训练微调。

在优化训练阶段,模型通常通过监督微调(SFT)、强化学习(RL)等方法,学习如何根据指令回答问题,使其行为更符合人类的偏好与需求,并激发在特定领域的专业潜力。

经过优化训练的模型能更有效地满足实际应用需求,从而具备部署上线的条件。

揭秘训练核心,锻造顶尖AI智能

DeepSeek模型卓越能力的背后,依赖于高质量、大规模且多样化的数据基础。

在「预训练阶段」和「优化训练阶段」,所使用的数据策略各有侧重。

预训练阶段

在预训练阶段,主要采用了以下两类数据源:

互联网上公开可获取的信息,例如各类网页、公开文档等。

通过与合作方签署协议获得授权使用的数据。

需要明确的是,在此阶段,训练过程无需也不涉及收集个人身份信息,DeepSeek不会有意将数据关联至任何特定账户或个人,更不会主动将其用于模型训练。

然而,由于预训练数据规模极其庞大,其中可能会偶然包含部分个人信息。

对此,DeepSeek会通过先进的技术手段,尽力识别并移除此类信息,确保训练数据的纯净与安全。

为了保障数据的质量、安全与多样性,他们构建了一套严谨的数据治理流程——

首先,通过多级「过滤器」自动清除原始数据中的仇恨言论、色情低俗内容、暴力信息、垃圾广告以及可能侵犯知识产权的材料。

其次,结合算法与人工审核,识别并尽力降低数据中存在的统计性偏见,促使模型生成更公平、客观的结果。

优化训练阶段

进入优化训练阶段,通常需要人工或自动化方式构建、标注一批问答对数据用于模型训练。

DeepSeek在此次说明中表示:这些问答对数据主要由研究团队生成提供,其中极小部分数据的构建可能会参考用户的输入。

在DeepSeek-R1的训练中,研究人员引导模型生成包含反思和验证步骤的详细答案;收集并整理DeepSeek-R1-Zero的输出以提升可读性;以及通过人工注释进行后期处理以优化数据质量

如涉及使用用户输入构建训练数据,DeepSeek将对数据进行严格的安全加密、彻底的脱敏和匿名化处理,从而最大限度避免训练数据与任何特定个人产生关联。这些数据不会出现在模型对其他用户的输出中,也不会被用于用户画像或个性化推荐。

同时,DeepSeek为用户提供了退出此类数据使用的选择权。

为了确保模型的安全性,在优化训练阶段,DeepSeek专门构建了安全对齐数据集对模型进行训练,教导其回复符合人类主流价值观,从而增强模型内在的安全防护能力。

模型推理阶段

模型的推理阶段即模型被部署后提供服务的阶段。

训练完成的模型部署后,能够通过对输入信息进行编码和复杂计算来预测后续的文本单元(token),从而具备文本生成和对话等能力。

部署后的模型能够熟练执行基于文本生成的各类任务,并可集成到多种下游系统或应用程序中。

具体到DeepSeek的产品服务,模型采用自回归生成方式,基于输入的上下文,通过概率计算预测最可能接续的词汇序列。

推理完成后,模型输出相应的内容作为响应,形式包括文字、表格和代码等。

此过程并非简单的信息检索或对训练数据的“复制粘贴”,模型并未存储原始训练数据的副本,而是基于对语言结构和语义关系的深层理解,动态生成符合当前语境的全新回答。

DeepSeek在此次说明中再次强调了其开源承诺。

我们通过开源平台对外公开发布了所有模型的权重、参数以及推理工具代码等,采用宽松的MIT开源协议,供使用者自由、免费下载与部署。

同时,DeepSeek发布各模型的完整技术报告,以供技术社区和研究人员参考,帮助公众更深入地理解每个模型的技术原理与实现细节。

应对LLM幻觉风险,实施全生命周期治理

毋庸置疑,当前人工智能技术仍处于发展早期,存在其固有的局限性。

若技术被不当滥用,可能带来严重的负面影响。

技术局限性

AI有时会生成错误、遗漏或与事实不符的内容,这一现象通常被称为“幻觉”。

这是整个AI行业共同面临的挑战。

对此,DeepSeek正通过多种技术手段努力降低幻觉发生率,包括使用高质量训练数据、优化对齐策略、引入检索增强生成(RAG)等,但现阶段仍无法完全根除。

同时,他们还在产品欢迎页面、生成文本的末尾以及交互界面底部,添加了显著的提示标识。

特别提醒用户——该内容由人工智能生成,可能存在不准确之处。

因此,AI生成的内容仅供参考,用户不应将其输出的内容视作专业建议。

尤其在医疗、法律、金融等高度专业化的领域,DeepSeek明确表示不提供任何建议或承诺,专业事务仍需咨询相关领域的专业人士。

技术滥用风险

AI技术本身是中立的,但其滥用可能引发隐私泄露、版权争议、数据安全、内容安全、偏见歧视等多重风险。

DeepSeek对此高度重视,采取了一系列贯穿模型研发、训练、部署全生命周期的严格措施。

制定并执行内部风险管理规范

定期开展模型安全性评估

进行对抗性红队测试

持续提升模型与服务的透明度

更重要的是,DeepSeek保障了用户的知情权、选择权与控制权——

用户可以查询服务的基本信息、拒绝其数据被用于模型训练、删除其历史交互数据等。

参考资料:

https://cdn.deepseek.com/policies/zh-CN/model-algorithm-disclosure.htmlDeepSeek 关于 AI 生成合成内容标识的公告

本文由主机测评网于2025-12-27发表在主机测评网_免费VPS_免费云服务器_免费独立服务器,如有疑问,请联系我们。

本文链接:https://vpshk.cn/20251213239.html